2026年最好的13个AI模型测评工具

MMLU, Open LLM Leaderboard, C-Eval, FlagEval, SuperCLUE, OpenCompass, CMMLU, MMBench, HELM, Chatbot Arena 是最好的付费/免费 AI模型测评工具

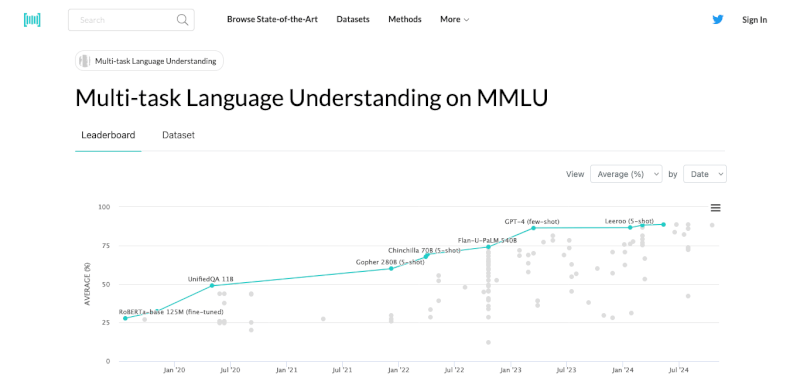

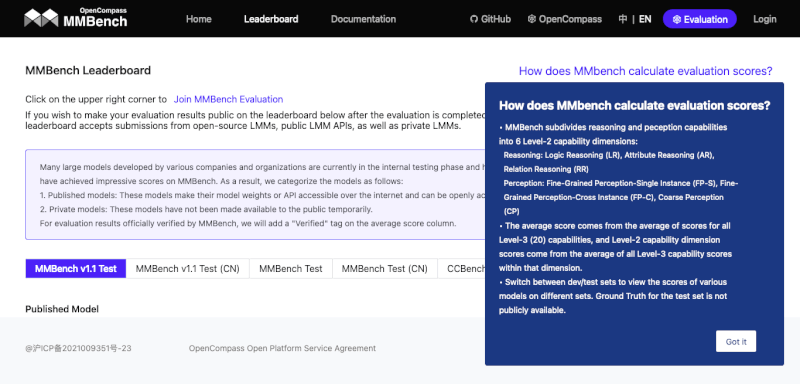

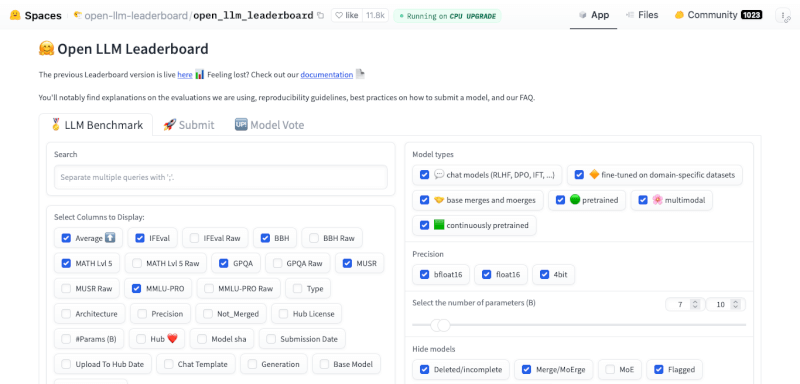

Open LLM Leaderboard

探索HuggingFace的Open LLM Leaderboard,一个用于评估开源大型语言模型性能的平台。了解其采用的四大关键基准测试,包括AI2推理挑战、HellaSwag、MMLU和TruthfulQA,如何全面评估模型能力。

免费

FlagEval

FlagEval(天秤)是智源研究院开发的全面大模型评测平台,采用三维评测框架,提供30多种能力、5种任务和4大类指标的评测,涵盖600多个维度,包含84,433道题目,旨在全面评估大模型性能。

免费

Chatbot Arena

Chatbot Arena是一个创新的大型语言模型评估平台,通过众包匿名对战方式比较模型性能。用户可参与评判,体验多轮对话,深入了解AI模型能力。由顶尖大学研究组织LMSYS Org开发,使用Elo评分系统进行公正评估。

免费

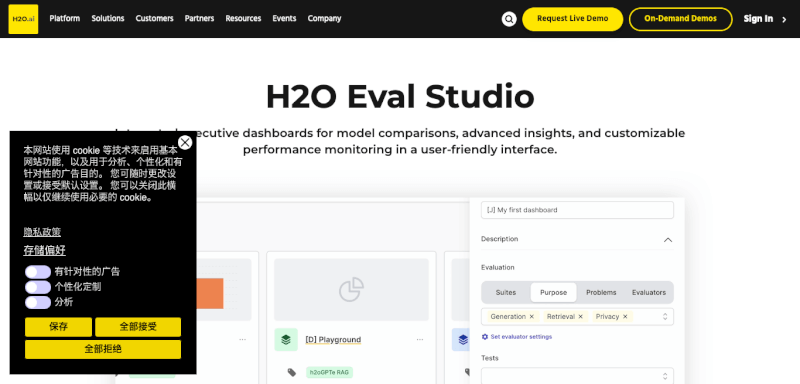

H2O EvalGPT

H2O EvalGPT是一款开放的大语言模型评估工具,提供全面的性能比较和详细排行榜。它具有相关性强、透明度高、更新迅速、覆盖范围广等特点,帮助用户选择最适合的模型来完成特定任务。

免费

- 上一页

- 1

- 下一页

什么是AI模型测评

AI工具类型页的介绍

AI模型测评的用户群体

用户群体

AI模型测评的工作原理

工作原理

AI模型测评的优势

优势

核心功能

核心功能